Die Benotung offener Fragen ist im Bildungswesen eine anspruchsvolle und gleichzeitig wichtige Aufgabe. Die Beurteilung von offenen Aufgabenstellungen ist allerdings zeitintensiv und aufwendig. Die Automatisierung dieses Prozesses mithilfe von KI kann zwei Vorteile mit sich bringen: Einerseits kann der Beurteilungsaufwand reduziert werden und anderseits kann die Beurteilung zu gleichmässigeren und objektiveren Ergebnissen führen, da der subjektiv menschliche Blick und Fehler minimiert werden könnten.

In der von der Internationalen Hochschule IU am 15. April 2024 veröffentlichten Studie «BEYOND HUMAN SUBJECTIVITY AND ERROR: A NOVEL AI GRADING SYSTEM» wurde diese Problematik mit Hilfe der neuesten Fortschritte in der Künstlichen Intelligenz angegangen. Ein automatisches Bewertungssystem für Kurzantworten wurde entwickelt, welches auf einem Open-Source-Transformationsmodell basiert. Nach einem umfangreichen Training mit Daten aus verschiedensten Universitätsprüfungen, stand die Überprüfung der Modellgenauigkeit an. Testdaten, die zuvor nie für Evaluationen genutzt wurden, kamen zum Einsatz. Das Ergebnis war bemerkenswert: Das System zeigte eine beeindruckende Präzision, nicht nur bei bekannten Fragestellungen, sondern auch bei solchen aus bisher unbekannten Kursen.

Beurteilung KI-Modell vs. Mensch

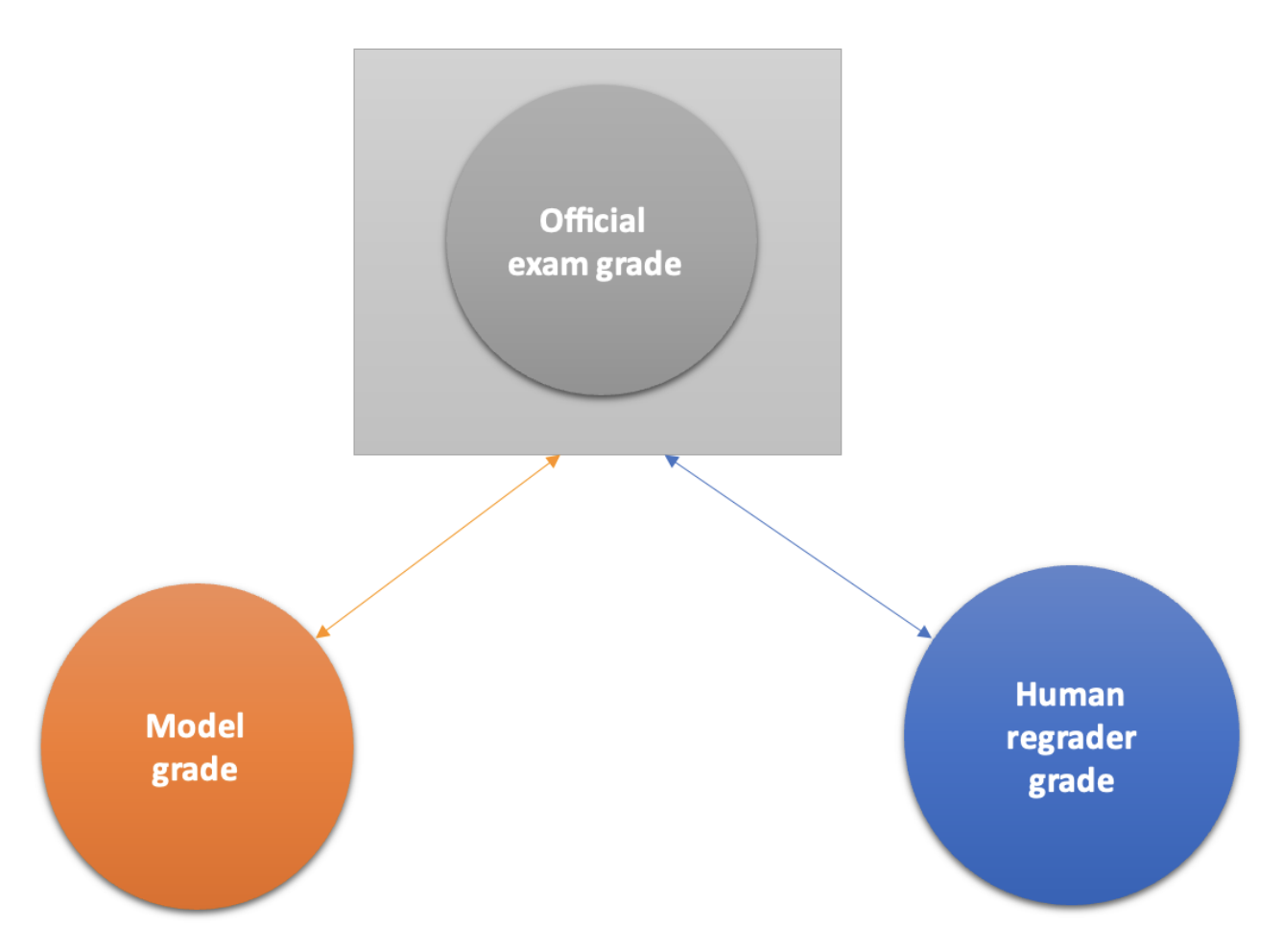

In einem zweiten Schritt wurde ein Experiment durchgeführt, in welchem die Leistung des KI-Modells mit der Beurteilung von menschlichen Fachexpert*innen verglichen wurde. Beide Gruppen wurden aufgefordert frühere Prüfungsantworten (1600 Frage-Antwort-Paare aus offiziellen Universitätsprüfungen unterschiedlichster Disziplinen) neu zu bewerten, ohne dass ihnen die ursprünglichen Noten bekannt waren. Die ursprünglichen Noten waren unbekannt, so dass die Bewertung möglichst unvoreingenommen passieren konnte.

Die Ergebnisse zeigten, dass das KI-Modell weniger von den ursprünglichen Bewertungen abwich als die Beurteilung durch die Fachexpert*innen. Konkret wird ersichtlich, dass der mittlere absolute Fehler des Modells um 44 % geringer war als der der menschlichen Bewertenden. Dies deutet darauf hin, dass die KI konsistenter bewertet hat.

Diese Ergebnisse zeigen, dass künstliche Intelligenz bei der Bewertung offener Antworten nicht nur die subjektive Einflüsse der Menschen reduzieren, sondern auch für gleichmässigere Noten sorgen kann. Dies könnte eine Möglichkeit sein, eine faire Bewertung im Bildungswesen zu fördern.

Die Forscher:innen der Internationalen Hochschule IU sind der Meinung, dass das getestete KI-Modell theoretisch schon als Bewertungssystem nutzbar wäre. Allerdings sind die rechtlichen und akademischen Rahmenbedingungen für den Einsatz von KI in der Bewertung noch nicht ausreichend entwickelt, weil die Technologie noch neu ist und sich die Vorschriften schnell ändern. Deswegen raten die IU-Expert:innen, vorerst ein Modell zu verwenden, das menschliche Prüfer:innen durch KI unterstützt, um Fehler zu minimieren und zu korrigieren.¨